APP开发的“隐形翅膀”:爬虫技术,数据获取的利器

在移动互联网的浪潮下,APP如同雨后春笋般层出不穷,它们以各种形态和功能丰富着我们的数字生活。从社交媒体到电商平台,从新闻资讯到在线教育,几乎每一个APP的背后,都离不开一个关键的环节——数据的获取与利用。而在这个数据驱动的时代,爬虫技术(WebScraping)无疑扮演着“数据魔法师”的角色,为APP的诞生与迭代提供了源源不断的信息“燃料”。

开发APP真的需要用到爬虫技术吗?答案并非一概而论,但可以肯定的是,在许多情况下,爬虫技术是APP开发过程中不可或缺的“隐形翅膀”。它就像一位勤劳的采集者,能够自动地、高效地从互联网的各个角落抓取我们所需的信息,并将其转化为APP能够理解和使用的结构化数据。

让我们来探讨一下APP开发为何会对爬虫技术产生如此强烈的需求。

海量数据的来源:互联网是一个巨大的信息宝库,其中蕴含着无数有价值的数据。例如,一个电商APP需要展示商品信息、用户评价、价格波动等;一个新闻APP需要聚合来自不同媒体的最新报道;一个旅游APP需要收集目的地攻略、酒店信息、机票价格等。这些数据往往分散在各个网站、论坛、API接口等地方,人工收集不仅效率低下,而且成本高昂。

爬虫技术能够自动抓取这些公开或半公开的数据,极大地减轻了开发者的负担,并保证了数据的时效性。

竞品分析与市场洞察:在激烈的市场竞争中,了解竞争对手的动态至关重要。通过爬虫技术,开发者可以定期抓取竞品APP的更新日志、用户评论、功能迭代、营销策略等信息,从而深入分析其优劣势,发现市场空白点,为自身产品的改进和创新提供决策依据。这种“知己知彼”的策略,是APP能够保持竞争力的关键。

个性化推荐与用户画像:现代APP越来越注重为用户提供个性化的体验。要实现这一点,就需要对用户的兴趣、偏好、行为习惯等进行深入分析,构建精准的用户画像。爬虫技术可以抓取与用户兴趣相关的公开信息(例如用户在社交媒体上分享的内容、关注的话题等),结合APP内部的用户行为数据,为算法模型提供更丰富、更多元的数据输入,从而实现更精准的推荐和内容推送。

数据驱动的决策与优化:APP的生命周期远不止于开发完成。持续的数据监测和分析是APP不断优化迭代的基础。爬虫技术可以帮助开发者持续抓取市场数据、用户反馈、行业趋势等,为产品的战略规划、功能调整、运营策略提供数据支持,确保APP能够始终紧跟市场需求,保持活力。

第三方数据集成:很多APP的功能需要与其他第三方服务或平台进行集成。例如,一个支付APP可能需要抓取银行的汇率信息,一个天气APP需要获取气象局发布的最新天气预报。如果这些数据没有提供现成的API接口,爬虫技术就可能成为获取这些数据的唯一途径。

让我们通过一些具体的例子来更直观地理解爬虫技术在APP开发中的应用。

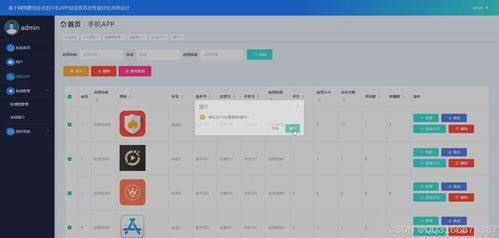

内容聚合类APP:比如一些聚合了多个新闻源、博客、论坛内容的APP,它们的核心功能就是通过爬虫技术从互联网上抓取海量信息,然后进行分类、整理、去重,最终以友好的界面呈现给用户。

比价类APP:这类APP的核心价值在于为用户提供跨平台、跨商家的商品价格比较。其背后的强大支撑正是爬虫技术,它能够定时或实时地抓取各大电商平台的商品价格、促销信息,并进行汇总对比。

招聘类APP:招聘APP需要从各大招聘网站、公司官网等渠道抓取职位信息、薪资待遇、公司介绍等。爬虫技术可以自动化这个过程,保证职位信息的时效性和全面性。

社交媒体分析工具:一些为企业或营销人员提供的社交媒体分析工具,会利用爬虫技术抓取特定话题下的用户评论、帖子、热度等数据,帮助用户了解舆情、评估营销效果。

数据可视化APP:某些APP专注于展示特定的数据图表和报告,例如股票行情APP、行业数据分析APP等。它们的数据来源往往是通过爬虫技术从金融网站、统计局、研究机构等渠道获取的。

当然,并非所有APP都必须使用爬虫技术。如果一个APP的功能完全依赖于用户生成内容(UGC),或者所有所需数据都能通过官方提供的API接口轻松获取,那么爬虫技术的重要性就会相对降低。在如今这个数据为王的时代,能够灵活运用爬虫技术,为APP注入源源不断的数据动力,无疑是提升APP核心竞争力的重要手段。

它就像APP开发中的“数据炼金术”,将散落在互联网上的“原材料”转化为创造价值的“黄金”。

虽然爬虫技术在APP开发中扮演着举足轻重的角色,但我们也要清醒地认识到,它并非万能的“灵丹妙药”,其应用也存在着边界和挑战。过度依赖或不当使用爬虫技术,反而可能给APP的开发和运营带来意想不到的麻烦。

法律与道德风险:这是使用爬虫技术时最需要警惕的方面。互联网上的数据并非全部属于公共领域。很多网站的数据受到版权保护,未经授权抓取可能构成侵权。一些敏感信息(如个人隐私数据)是绝对禁止抓取的。不遵守网站的robots.txt协议,或者恶意、高频的抓取行为,可能被视为非法行为,导致IP被封、法律诉讼,甚至承担刑事责任。

因此,在进行爬虫开发前,务必深入了解相关法律法规,并恪守商业道德。

网站结构变化带来的维护难题:互联网是动态变化的,网站的结构、布局、HTML标签等都可能随时更新。一旦被抓取网站的结构发生变化,原本编写好的爬虫程序很可能就失效了,需要花费大量的时间和精力去维护、更新和调试。这种“牵一发而动全身”的维护成本,是许多APP开发者头疼的问题。

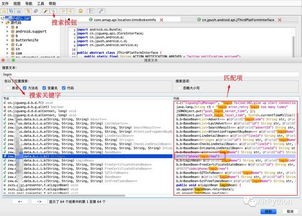

反爬虫机制的对抗:很多网站为了保护自身数据不被过度抓取,会采取各种反爬虫技术。例如,验证码识别、IP频率限制、动态加载内容(JavaScript渲染)、用户行为模拟检测等。这些机制大大增加了爬虫开发的难度,需要开发者具备更深厚的技术功底,并不断学习和应对新的反爬虫策略。

数据质量与准确性:爬虫抓取的数据并非总是完美无缺。原始数据可能存在格式不统一、信息缺失、错误信息、重复数据等问题。如何在抓取后进行有效的数据清洗、去重、校验,保证数据的准确性和可用性,是爬虫应用中一个不可忽视的环节。低质量的数据只会误导APP的决策,影响用户体验。

技术门槛与开发成本:虽然有一些现成的爬虫框架和工具,但开发一个稳定、高效、可扩展的爬虫系统,仍然需要一定的技术投入。开发者需要熟悉至少一种编程语言(如Python、Java)、掌握HTTP协议、HTML解析库(如BeautifulSoup、lxml)、以及应对各种反爬策略的技术。

数据处理与存储的压力:爬虫能够抓取大量数据,但如何有效地存储、管理和处理这些数据,是另一个挑战。尤其是当数据量级达到TB甚至PB级别时,就需要考虑分布式存储、数据库优化、大数据处理技术(如Hadoop、Spark)等。

鉴于上述挑战,APP开发者在决定是否使用爬虫技术以及如何使用时,需要进行审慎的评估。

优先考虑官方API:在条件允许的情况下,优先使用目标网站或服务提供的官方API接口。API通常更稳定、合法,且能提供结构化、高质量的数据,可以大大降低开发和维护成本。

合法合规是前提:严格遵守robots.txt协议,尊重网站的爬取规则。避免抓取受版权保护或涉及隐私的数据。如果需要抓取商业敏感信息,务必事先获得授权。

从小范围、低频次开始:对于非核心需求,可以先从小范围、低频次的抓取开始,例如只抓取特定页面的少量信息,或者设置较长的抓取间隔。通过测试和监控,逐步评估其可行性和稳定性。

选择合适的工具与框架:Python的Scrapy、BeautifulSoup,以及一些无头浏览器(如Selenium、Puppeteer)都是常用的爬虫开发工具。选择适合自己技术栈和需求的技术,可以提高开发效率。

建立完善的错误处理与监控机制:爬虫程序需要具备良好的容错能力,能够应对网络波动、网站结构变化等异常情况。建立完善的日志记录和监控系统,及时发现和处理问题。

数据清洗与后处理:抓取到的原始数据往往需要经过大量的清洗、转换和校验,才能真正投入使用。可以考虑构建专门的数据处理管道,保证数据质量。

考虑数据替代方案:如果爬虫的维护成本过高,或者存在较高的法律风险,可以考虑寻找其他数据来源,例如购买第三方数据服务,或者与数据提供方建立合作关系。

专注于核心业务:爬虫技术本身只是获取数据的手段,最终的目的是为APP的核心业务服务。开发者应将更多的精力放在如何利用抓取到的数据创造价值,提升用户体验,而不是陷入无休止的爬虫维护中。

总而言之,爬虫技术对于许多APP的开发而言,是获取关键数据、分析市场、实现个性化功能的重要工具,是APP发展的“助推器”。它并非银弹,也伴随着法律、技术和维护上的重重挑战。开发者需要具备清醒的认知,权衡利弊,在合法合规的前提下,以智慧和审慎的态度去驾驭这项技术。

明智地运用爬虫,可以为APP插上数据翅膀,腾飞于竞争激烈的市场;而盲目或不当的使用,则可能带来难以承受的风险和代价。因此,理解爬虫技术的边界,并将其巧妙地融入APP开发的策略中,才是通往成功的关键。